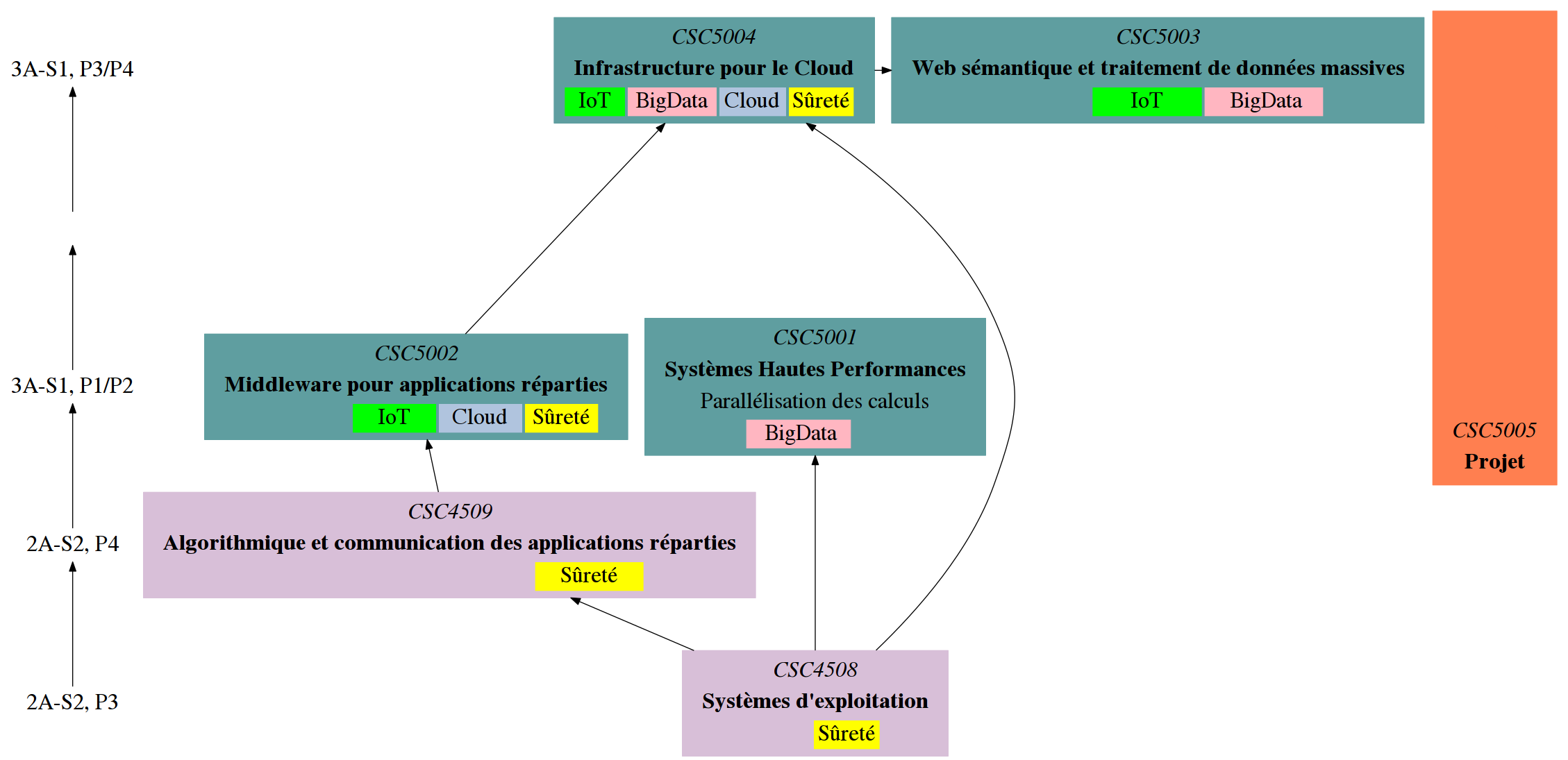

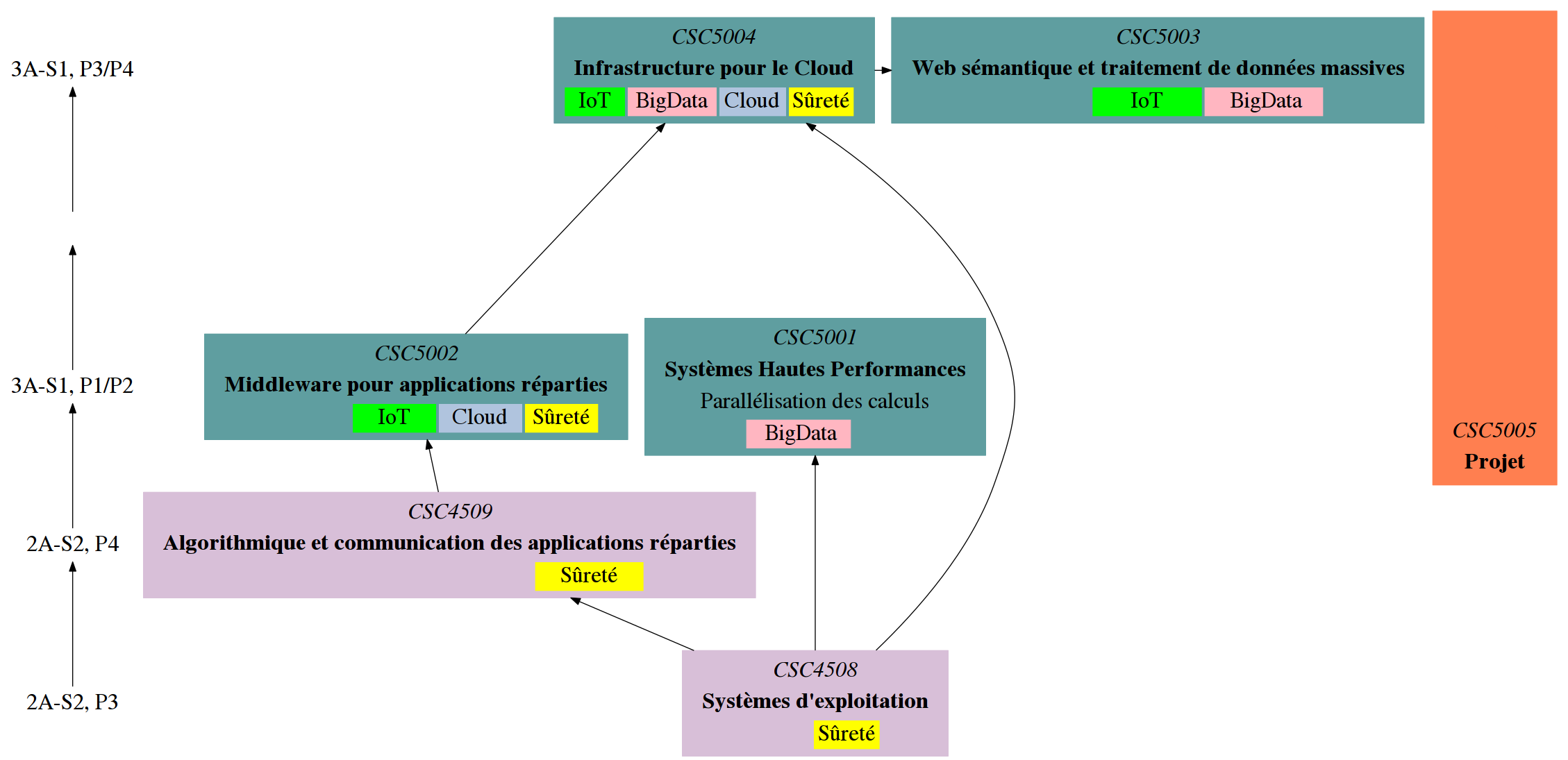

Organisation et contenu des modules d'enseignement

Les objectifs pédagogiques ainsi que le contenu de ces UVs est accessible ci-dessous (cliquer sur une UV pour en savoir plus).

Pour continuer :

Les objectifs pédagogiques ainsi que le contenu de ces UVs est accessible ci-dessous (cliquer sur une UV pour en savoir plus).